O arquivo Robots.txt informa aos mecanismos de pesquisa como rastrear seu site, o que o torna uma ferramenta de SEO incrivelmente poderosa.

Neste artigo, mostraremos como criar um arquivo robots.txt perfeito para SEO.

O que é arquivo robots.txt?

Robots.txt é um arquivo de texto que os proprietários de sites podem criar para informar aos bots de mecanismos de pesquisa como rastrear e indexar páginas em seus sites.

Normalmente é armazenado no diretório raiz, também conhecido como pasta principal, do seu site. O formato básico de um arquivo robots.txt é parecido com este:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

Você pode ter várias linhas de instruções para permitir ou proibir URLs específicos e adicionar vários sitemaps. Se você não proibir um URL, os bots do mecanismo de pesquisa presumem que têm permissão para rastreá-lo.

Esta é a aparência de um arquivo de exemplo robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

No exemplo de robots.txt acima, permitimos que os mecanismos de pesquisa rastreiem e indexem arquivos em nossa pasta de uploads do WordPress.

Depois disso, não permitimos que os bots de pesquisa rastreiem e indexem plug-ins e pastas de administração do WordPress.

Por último, fornecemos o URL do nosso mapa do site XML.

Você precisa de um arquivo Robots.txt para o seu site WordPress?

Se você não tiver um arquivo robots.txt, os mecanismos de pesquisa ainda rastrearão e indexarão o seu site. No entanto, você não poderá dizer aos mecanismos de pesquisa quais páginas ou pastas eles não devem rastrear.

Isso não terá muito impacto quando você iniciar um blog e não tiver muito conteúdo.

No entanto, à medida que seu site cresce e você tem muito conteúdo, provavelmente deseja ter um controle melhor sobre como seu site é rastreado e indexado.

Aqui está o porquê.

Os bots de pesquisa têm uma cota de rastreamento para cada site.

Isso significa que eles rastreiam um determinado número de páginas durante uma sessão de rastreamento. Se eles não terminarem de rastrear todas as páginas do seu site, eles voltarão e retomarão o rastreamento na próxima sessão.

Isso pode diminuir a taxa de indexação do seu site.

Você pode corrigir isso impedindo que os robôs de pesquisa tentem rastrear páginas desnecessárias, como suas páginas de administração do WordPress, arquivos de plug-in e pasta de temas.

Ao proibir páginas desnecessárias, você salva sua cota de rastreamento. Isso ajuda os mecanismos de pesquisa a rastrear ainda mais páginas em seu site e a indexá-las o mais rápido possível.

Outro bom motivo para usar o arquivo robots.txt é quando você deseja impedir que os mecanismos de pesquisa indexem uma postagem ou página em seu site.

Não é a maneira mais segura de ocultar o conteúdo do público em geral, mas o ajudará a evitar que apareça nos resultados da pesquisa.

Qual é a aparência de um arquivo Robots.txt ideal?

Muitos blogs populares usam um arquivo robots.txt muito simples. Seu conteúdo pode variar, dependendo das necessidades do site específico:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Este arquivo robots.txt permite que todos os bots indexem todo o conteúdo e fornece a eles um link para os mapas do site XML do site.

Para sites WordPress, recomendamos as seguintes regras no arquivo robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Isso diz aos robôs de pesquisa para indexar todas as imagens e arquivos do WordPress. Ele não permite que os bots de pesquisa indexem arquivos de plug-in do WordPress, a área de administração do WordPress, o arquivo leia-me do WordPress e links de afiliados.

Ao adicionar mapas de sites ao arquivo robots.txt, você torna mais fácil para os bots do Google encontrarem todas as páginas do seu site.

Agora que você sabe como é um arquivo robots.txt ideal, vamos dar uma olhada em como você pode criar um arquivo robots.txt no WordPress.

Como criar um arquivo Robots.txt no WordPress?

Existem duas maneiras de criar um arquivo robots.txt no WordPress. Você pode escolher o método que funciona melhor para você.

Método 1: Editando o arquivo Robots.txt usando All in One SEO

Tudo em um SEO também conhecido como AIOSEO é o melhor plugin de SEO para WordPress do mercado usado por mais de 2 milhões de sites.

É fácil de usar e vem com um gerador de arquivo robots.txt.

Se você ainda não instalou o plug-in AIOSEO, consulte nosso guia passo a passo sobre como instalar um plug-in WordPress.

Observação: Versão gratuita do AIOSEO também está disponível e tem esse recurso.

Depois que o plug-in estiver instalado e ativado, você pode usá-lo para criar e editar seu arquivo robots.txt diretamente da área de administração do WordPress.

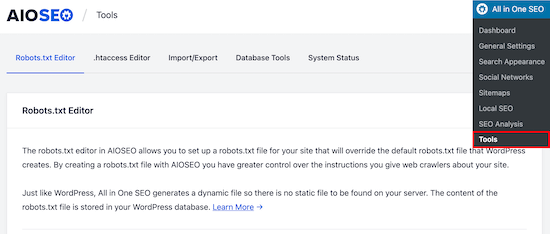

Simplesmente vá para Tudo em um SEO »Ferramentas para editar seu arquivo robots.txt.

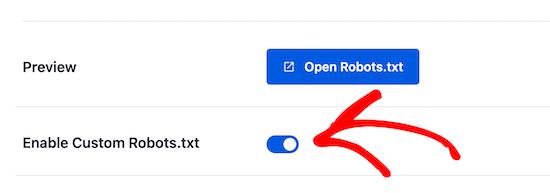

Primeiro, você precisa ativar a opção de edição, clicando no botão ‘Enable Custom Robots.txt’ para mudar para azul.

Com essa chave ativada, você pode criar um arquivo robots.txt personalizado no WordPress.

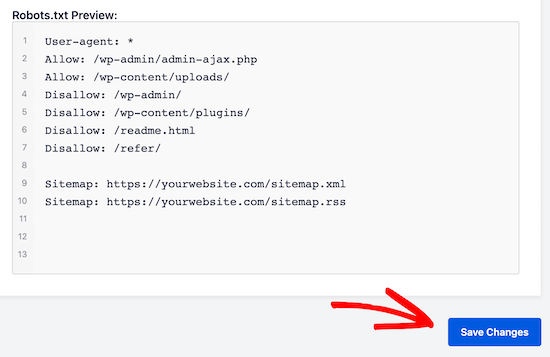

O All in One SEO mostrará o arquivo robots.txt existente na seção ‘Visualização do Robots.txt’ na parte inferior da tela.

Esta versão irá mostrar as regras padrão que foram adicionadas pelo WordPress.

Essas regras padrão dizem aos mecanismos de pesquisa para não rastrearem seus arquivos principais do WordPress, permitem que os bots indexem todo o conteúdo e fornece a eles um link para os mapas do site XML do seu site.

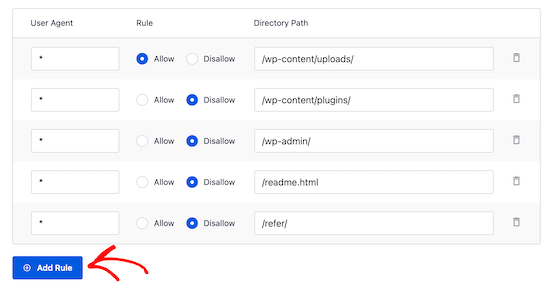

Agora, você pode adicionar suas próprias regras personalizadas para melhorar seu robots.txt para SEO.

Para adicionar uma regra, insira um agente do usuário no campo ‘Agente do usuário’. Usar um * aplicará a regra a todos os agentes do usuário.

Em seguida, selecione se deseja ‘Permitir’ ou ‘Não permitir’ que os mecanismos de pesquisa façam o rastreamento.

Em seguida, digite o nome do arquivo ou o caminho do diretório no campo ‘Caminho do diretório’.

A regra será aplicada automaticamente ao seu robots.txt. Para adicionar outra regra, clique no botão ‘Adicionar regra’.

Recomendamos adicionar regras até criar o formato robots.txt ideal que compartilhamos acima.

Suas regras personalizadas ficarão assim.

Assim que terminar, não se esqueça de clicar no botão ‘Salvar alterações’ para armazenar suas alterações.

Método 2. Editar o arquivo Robots.txt manualmente usando FTP

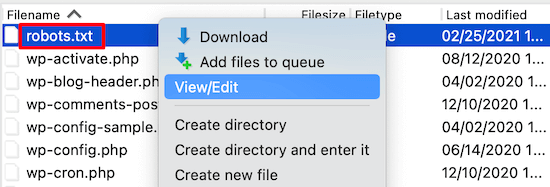

Para este método, você precisará usar um cliente FTP para editar o arquivo robots.txt.

Basta conectar-se à sua conta de hospedagem WordPress usando um cliente FTP.

Uma vez lá dentro, você poderá ver o arquivo robots.txt na pasta raiz do seu site.

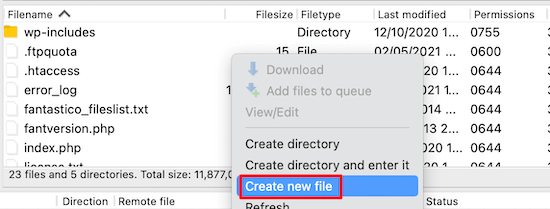

Se você não encontrar um, provavelmente não tem um arquivo robots.txt.

Nesse caso, você pode simplesmente criar um.

Robots.txt é um arquivo de texto simples, o que significa que você pode baixá-lo para o seu computador e editá-lo usando qualquer editor de texto simples, como o Notepad ou TextEdit.

Depois de salvar suas alterações, você pode enviá-lo de volta para a pasta raiz do seu site.

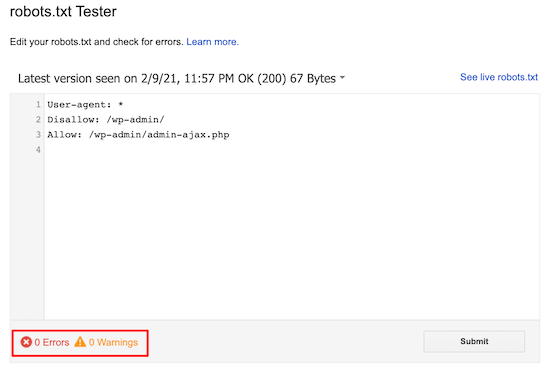

Como testar o arquivo Robots.txt?

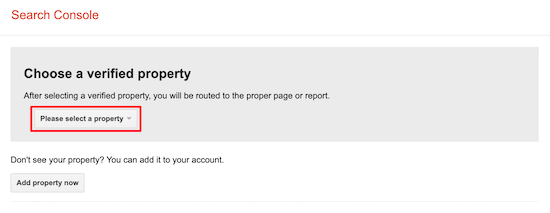

Depois de criar seu arquivo robots.txt, é sempre uma boa ideia testá-lo usando uma ferramenta de teste de robots.txt.

Existem muitas ferramentas de teste de robots.txt por aí, mas recomendamos o uso de uma dentro do Google Search Console.

Primeiro, você precisa ter seu site vinculado ao Google Search Console. Se você ainda não fez isso, consulte nosso guia sobre como adicionar seu site WordPress ao Google Search Console.

Então, você pode usar o Ferramenta de teste de robôs do Google Search Console.

Basta selecionar sua propriedade na lista suspensa.

A ferramenta buscará automaticamente o arquivo robots.txt do seu site e destacará os erros e avisos, se houver algum.

Conclusão

O objetivo de otimizar seu arquivo robots.txt é evitar que os mecanismos de pesquisa rastreiem páginas que não estão disponíveis publicamente. Por exemplo, páginas em sua pasta wp-plugins ou páginas em sua pasta de administração do WordPress.

Um mito comum entre os especialistas em SEO é que o bloqueio de categorias, tags e páginas de arquivo do WordPress melhorará a taxa de rastreamento e resultará em indexação mais rápida e classificações mais altas.

Isso não é verdade. Também é contra as diretrizes para webmasters do Google.

Recomendamos que você siga o formato robots.txt acima para criar um arquivo robots.txt para o seu site.

Esperamos que este artigo tenha ajudado você a aprender como otimizar seu arquivo robots.txt do WordPress para SEO. Você também pode querer ver nosso guia final de SEO para WordPress e as melhores ferramentas de SEO para WordPress para expandir seu site.